이재환 교수 연구팀, AI 데이터센터 CPU 병목 문제 해결 연구 IEEE BigData 2025서 발표

- 2025-12-24

우리 대학 컴퓨터공학과 이재환 교수 연구팀이 AI 데이터센터의 CPU 병목 문제를 해결하는 시스템 아키텍처 연구를 IEEE International Conference on Big Data 2025에서 발표했다. IEEE BigData는 빅데이터의 이론, 알고리즘, 시스템 및 응용 분야를 다루는 국제 학술대회로, 올해로 13회를 맞았다.

이번 연구는 우리 대학 컴퓨터공학과 이재환 교수(교신저자, 빅데이터 및 분산 컴퓨팅 연구실)와 석사과정 이유찬 학생이 한국전자통신연구원(ETRI)과 공동으로 수행했다. 연구팀은 AI와 클라우드 컴퓨팅 수요 증가로 데이터센터 환경에서 CPU에 과도한 작업이 집중되며 성능 저하가 발생하는 문제에 주목했다.

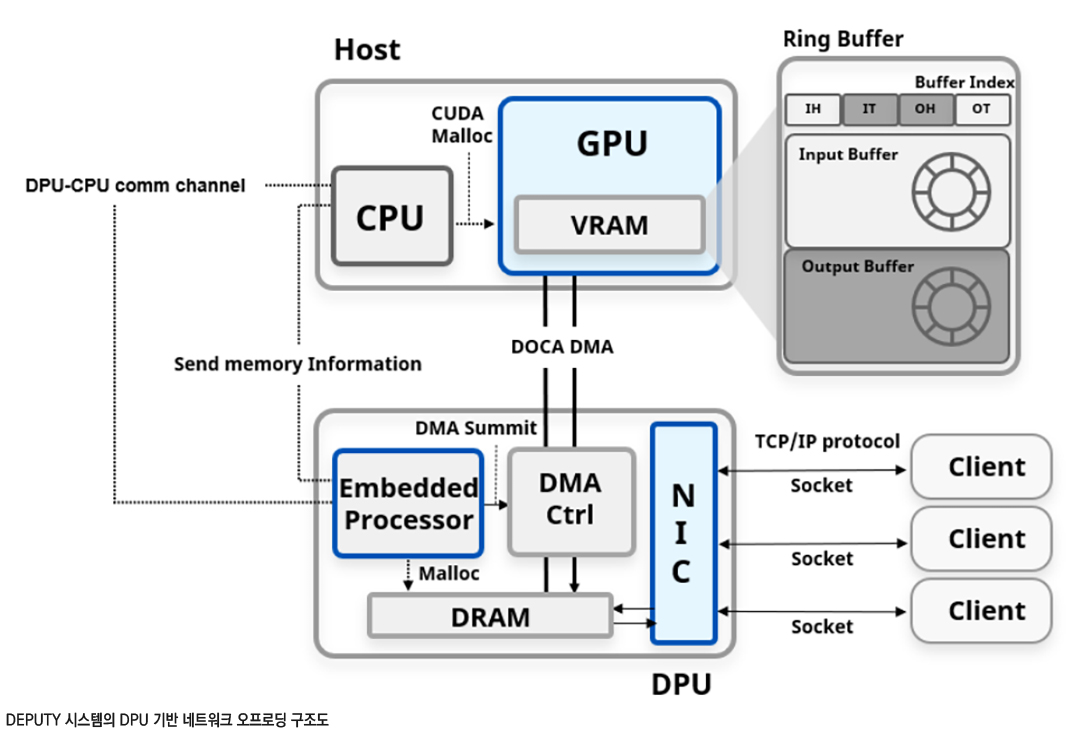

연구팀의 논문 <DEPUTY: A DPU-Based Network Offloading Architecture with Minimal CPU Involvement for Stable Network Performance>는 이러한 문제를 해결하기 위해 DPU(Data Processing Unit‧네트워크와 데이터 처리를 전담하는 전용 프로세서)를 활용한 새로운 시스템 구조를 제안했다. 기존 연구들은 CPU 병목을 완화하기 위해 GPU 자원을 추가로 소모하거나, 복잡한 시스템 설정 또는 고가의 장비 도입을 요구하는 한계가 있었다. 이에 연구팀은 CPU가 담당하던 네트워크 처리와 GPU 작업 관리 기능을 분리해 CPU 개입을 최소화하는 방식에 초점을 맞췄다.

GPU(Graphics Processing Unit‧대규모 연산을 병렬로 처리하는 장치)는 AI 학습과 추론 과정에서 핵심적인 역할을 수행하는 연산 자원으로, CPU보다 훨씬 많은 계산을 동시에 처리할 수 있다는 특징이 있다. 그러나 기존 데이터센터 구조에서는 GPU 활용 과정에서도 CPU의 개입이 많아 병목 현상이 발생해 왔다.

연구팀은 네트워크 처리를 DPU로 이전하고, GPU 작업을 CUDA Graph(여러 GPU 연산을 하나의 그래프 형태로 묶어 실행 효율을 높이는 기술) 기반으로 구성함으로써 CPU 개입 없이 동작하는 시스템을 구현했다. 이 방식은 기존 사용자 접근 방식을 그대로 유지할 수 있어 AI 및 클라우드 컴퓨팅 환경 전반에 적용하기 용이하다는 장점이 있다.

실험 결과, 제안된 시스템은 기존 방식 대비 최대 1.96배의 처리량 향상을 보였으며, CPU 부하 없이도 GPU 자원을 효율적으로 활용할 수 있음을 확인했다. 이는 데이터센터 환경에서 시스템 자원 활용 효율을 높이고 안정적인 네트워크 성능을 확보하는 데 기여할 수 있는 성과로 평가된다.

이재환 교수는 “이번 연구는 데이터센터 환경에서 CPU 병목 문제를 해결할 수 있는 새로운 방향을 제시했다”며, “향후 대규모 AI 및 클라우드 시스템에 폭넓게 적용될 수 있을 것으로 기대한다”고 말했다.

- 이전글 이전글이 없습니다.

- 다음글 신명훈 교수, 투명 태양광 창호 기술 개발… 국제학술지 Joule 게재